Trí tuệ nhân tạo (AI) đang dần thay đổi cách chúng ta sống và làm việc, nó mang lại những đột phá công nghệ không tưởng. Tuy nhiên, công nghệ này cũng đang bị kẻ xấu lạm dụng để tạo ra các chiêu trò lừa đảo tinh vi.

Gia tăng lừa đảo bằng AI

Trong thời đại số hóa, lừa đảo qua mạng không chỉ đơn thuần là những email giả mạo thô sơ hay các cuộc gọi mạo danh đơn giản. Giờ đây kẻ gian có thể tận dụng AI để thực hiện các chiêu trò lừa đảo tinh vi hơn, như deepfake (công nghệ sử dụng AI và machine learning (học máy) để tạo ra các video, hình ảnh hoặc âm thanh giả mạo có độ chân thực rất cao).

Công nghệ này có thể dễ dàng “gán” khuôn mặt của một người vào cơ thể của một người khác trong video hoặc thậm chí sao chép giọng nói của họ chỉ trong vài giây. Những sản phẩm deepfake này có thể được kẻ gian sử dụng để thực hiện các hành vi đe dọa, tống tiền và làm tổn hại đến danh dự của nạn nhân. Điều này khiến việc phát hiện các chiêu trò lừa đảo trở nên khó khăn hơn bao giờ hết và nếu người dùng không trang bị đầy đủ kiến thức sẽ rất dễ rơi vào bẫy.

Theo một nghiên cứu gần đây của Censuswide (công ty tư vấn chuyên về nghiên cứu thị trường), hơn 25% người tham gia khảo sát đã thừa nhận họ từng là nạn nhân của các vụ lừa đảo có liên quan đến AI, chủ yếu là giả mạo danh tính. Điều này cho thấy mức độ tinh vi mà AI mang lại, đặc biệt là công nghệ deepfake.

Thực tế hơn một nửa số người tham gia khảo sát cho rằng công nghệ hiện tại chưa đủ khả năng bảo vệ danh tính của họ trước các vụ tấn công bằng deepfake.

45% số người tham gia tin rằng cần phải có sự can thiệp của pháp luật với các quy định nghiêm ngặt hơn để kiểm soát việc sử dụng AI cho mục đích lừa đảo.

Trao đổi với PV, anh Ngọc Minh (ngụ TP.HCM) cho biết bản thân từng là nạn nhân của các trò lừa đảo bằng AI. Cụ thể, anh đã bị kẻ xấu thu thập hình ảnh cá nhân rồi sử dụng deepfake để ghép mặt vào các video nhạy cảm và bị tống tiền. Tuy nhiên, anh đã chọn giải pháp không thỏa hiệp và chia sẻ thông tin lên Facebook cũng như các nền tảng khác để cảnh báo cho bạn bè, người thân.

Đầu năm 2024, Trung tâm Xử lý tin giả, thông tin xấu độc Việt Nam đã nhận được phản ánh từ một chủ tịch tập đoàn vận tải về việc ông bị kẻ xấu sử dụng deepfake để phát tán hình ảnh giả mạo trên mạng. Những vụ việc như vậy không chỉ làm ảnh hưởng nghiêm trọng đến danh dự cá nhân mà còn gây hoang mang trong cộng đồng.

Mới đây, Phòng An ninh mạng và phòng, chống tội phạm sử dụng công nghệ cao (PA05) Công an TP.HCM cũng nhận được thông tin trình báo của một số nạn nhân liên quan đến việc bị giả mạo danh tính, ghép mặt vào các hình ảnh, video nhạy cảm.

Đại diện đơn vị này cho biết chiêu trò kẻ gian sử dụng thường là theo dõi nạn nhân trong thời gian dài trên các nền tảng mạng xã hội. Sau đó kết bạn để thu thập thông tin cá nhân, hình ảnh công khai và sử dụng deepfake để tạo video nhạy cảm giả mạo, đe dọa, gây áp lực gửi cho những người quen qua mạng xã hội để tống tiền.

Ông Ngô Minh Hiếu, chuyên gia kỹ thuật tại Trung tâm Giám sát an toàn không gian mạng quốc gia (NCSC) thuộc Bộ TT&TT, cho biết một số trường hợp còn giả mạo cơ quan công an, cơ quan chức năng khác như ngân hàng, điện lực để dẫn dụ nạn nhân cài đặt ứng dụng độc hại lên điện thoại, sau đó chiếm đoạt tài sản...

Cách nào để nhận diện và phòng tránh lừa đảo bằng AI?

Nhằm đối phó với những chiêu trò lừa đảo ngày càng tinh vi, người dùng cần nâng cao nhận thức và trang bị cho mình những biện pháp phòng tránh hiệu quả.

Theo ông Nguyễn Tiến Đạt, Tổng Giám đốc Trung tâm Nghiên cứu mã độc AntiMalware của Bkav, AI đã giúp kẻ gian có khả năng thu thập và phân tích dữ liệu của người dùng, từ đó tạo ra những chiến lược lừa đảo tinh vi. Đặc biệt, khi kết hợp deepfake với các công cụ chatbot AI, các kịch bản lừa đảo trở nên phức tạp và khó phát hiện hơn.

Một số báo cáo cho thấy chỉ với một đoạn âm thanh mẫu khoảng 3 giây, tội phạm mạng có thể dễ dàng sao chép giọng nói của một người để thực hiện các cuộc gọi giả mạo.

Chia sẻ với PV, ông Võ Đỗ Thắng, Giám đốc Trung tâm An ninh mạng Athena, cho rằng người dùng có thể dựa vào một số dấu hiệu để nhận biết video, hình ảnh giả mạo. Ví dụ người xem có thể chú ý đến các chi tiết như biểu cảm khuôn mặt, ánh sáng, chuyển động của môi hoặc chất lượng âm thanh. Nếu các yếu tố này không tự nhiên hoặc không đồng nhất, có khả năng đó là video giả mạo được tạo ra bằng deepfake.

Mặc dù vậy, với sự phát triển của công nghệ, các hình ảnh do AI tạo ra gần như đã không có sự khác biệt và rất khó để phân biệt nếu không sử dụng những công cụ phân tích. Đồng quan điểm, ông Ngô Minh Hiếu cho rằng để nhận diện video giả mạo, người dùng cần để ý các biểu cảm trên khuôn mặt, hướng đầu hoặc các cử chỉ.

Bà Lisa Grahame, Giám đốc an ninh thông tin của Ngân hàng Starling (Vương quốc Anh), cũng đưa ra một gợi ý hữu ích: Mọi người nên tự đặt ra một “cụm từ an toàn” chỉ có người thân hoặc bạn bè thân thiết biết. Cụm từ này có thể được sử dụng để xác minh danh tính khi trò chuyện, đặc biệt là khi có liên quan đến tiền bạc. Ví dụ nếu ai đó mượn tiền của bạn nhưng không biết được cụm từ an toàn, rất có thể đó là kẻ giả mạo danh tính.

Làm gì khi bị tống tiền bằng video nhạy cảm giả mạo?

Khi bị tống tiền bằng video nhạy cảm giả mạo, điều quan trọng là không nên hoảng loạn hay thỏa hiệp.

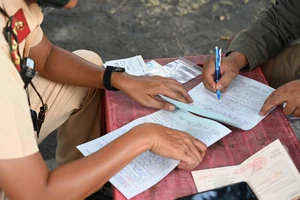

ThS - luật sư Nguyễn Minh Trí, Trưởng Văn phòng luật sư Trí Phúc, khuyến cáo nạn nhân nên giữ nguyên file gốc, hình ảnh hoặc link của video tống tiền và liên hệ với công an phường hoặc PA05 để khai báo sự việc. Thêm vào đó, việc cung cấp thông tin về những ai có hiềm khích trong cuộc sống có thể giúp cơ quan chức năng xem xét và điều tra sâu hơn.

Tương tự, ông Ngô Minh Hiếu cũng khuyến cáo người dùng cần đặc biệt nâng cao cảnh giác, không cung cấp thông tin nhạy cảm như thẻ căn cước, tài khoản ngân hàng, OTP… cho bất kỳ ai, kể cả khi họ tự xưng là nhân viên ngân hàng hoặc cơ quan nhà nước. Đặc biệt không chuyển tiền cho người lạ qua điện thoại, mạng xã hội hoặc các trang web có dấu hiệu lừa đảo. Đồng thời báo cáo sự việc với NCSC hoặc các chuyên gia bảo mật để được tư vấn, hỗ trợ ngăn chặn sự lan truyền của nội dung giả mạo.

Dù AI có phát triển đến đâu, yếu tố con người vẫn là trung tâm trong việc ngăn chặn các hành vi lừa đảo. Sự cẩn trọng trong việc chia sẻ thông tin cá nhân, luôn cảnh giác trước những dấu hiệu đáng ngờ và báo cáo kịp thời cho các cơ quan chức năng khi phát hiện dấu hiệu lừa đảo là những biện pháp hữu ích giúp bảo vệ bản thân và cộng đồng trước những nguy cơ do lạm dụng AI gây ra.